Taller de ética

bikoschool

ujué :: karlos

@ujue @patxangas

Bikolabs Laboratorio de especulación

Nos conformamos con estar 20 minutos por delante

Explorar y reflexionar sobre la potencia e implicaciones

de la relación tecnología-personas

hoy y en el futuro.

QUÉ ES ESTO DE LA ÉTICA

un campo que concierne a los valores y comportamientos humanos, lo que es moralmente correcto o incorrecto

UTILITARISMO

MARCOS ÉTICOS

Buscar la mejores consecuencias posibles para la mayoría de personas, en términos de felicidad. La acción no es buena ni mala, depende de las consecuencias.

Ej. vigilancia institucional del uso tecnología ciudadana por seguridad nacional.

DEONTOLOGÍA

La moralidad de una acción está determinada por lo correcto o incorrecto de la acción en sí basada en reglas. Personas como fin, no medio.

Ej. decir la verdad a un psicópata o un enfermo terminal con depresión porque la mentira no está aceptada.

TEORÍA DE LA JUSTICIA

Justicia como equidad. Garantizar que todo el mundo tiene un mismo acceso a recursos básicos como vivienda, trabajo, educación, etc sin discriminación

Ej. un sistema de créditos ciego a la raza no sería justo porque las minorías raciales tienden a tener muchos menos recursos económicos

ÉTICA DE LAS VIRTUDES

Necesitamos así de sabiduría práctica para ver qué virtud es la más adecuada. Frente a los otros modelos dicotómicos, se puede ser más o menos virtuoso.

Ej. ayudamos a un anciano a cruzar la calle por la virtud de la caridad o la benevolencia

EJERCICIO VELO DE IGNORANCIA

MATRIZ ÉTICA

SALMÓN MODIFICADO GENÉTICAMENTE PARA QUE CREZCA MÁS RÁPIDO

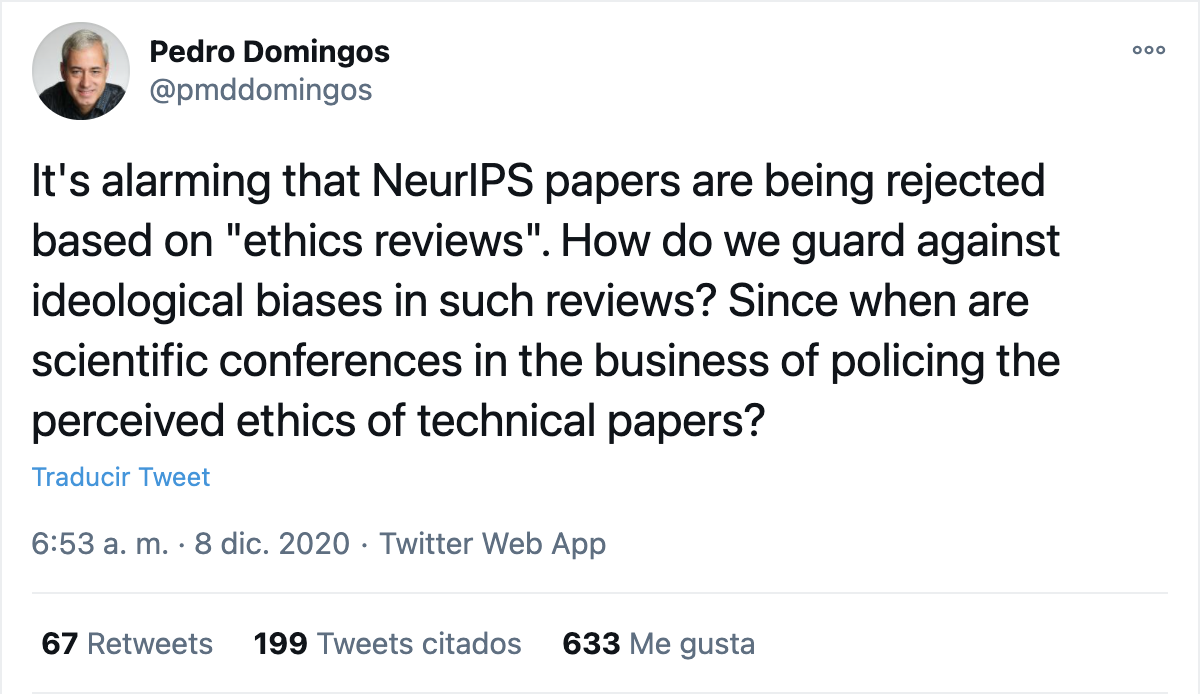

POR QUÉ UNA REFLEXIÓN ÉTICA

LAS REPERCUSIONES ÉTICAS

DE ALGUNAS DE LAS ASUNCIONES DE NUESTRO SECTOR

EL SUPUESTO DE QUE LA TECNOLOGÍA ES NEUTRAL

EL SUPUESTO DE QUE EL MERCADO PRIMA EL USER CENTRIC

SUPUESTO USER CENTRIC

EL USUARIO NORMALMENTE

NO ESTÁ EN EL CENTRO

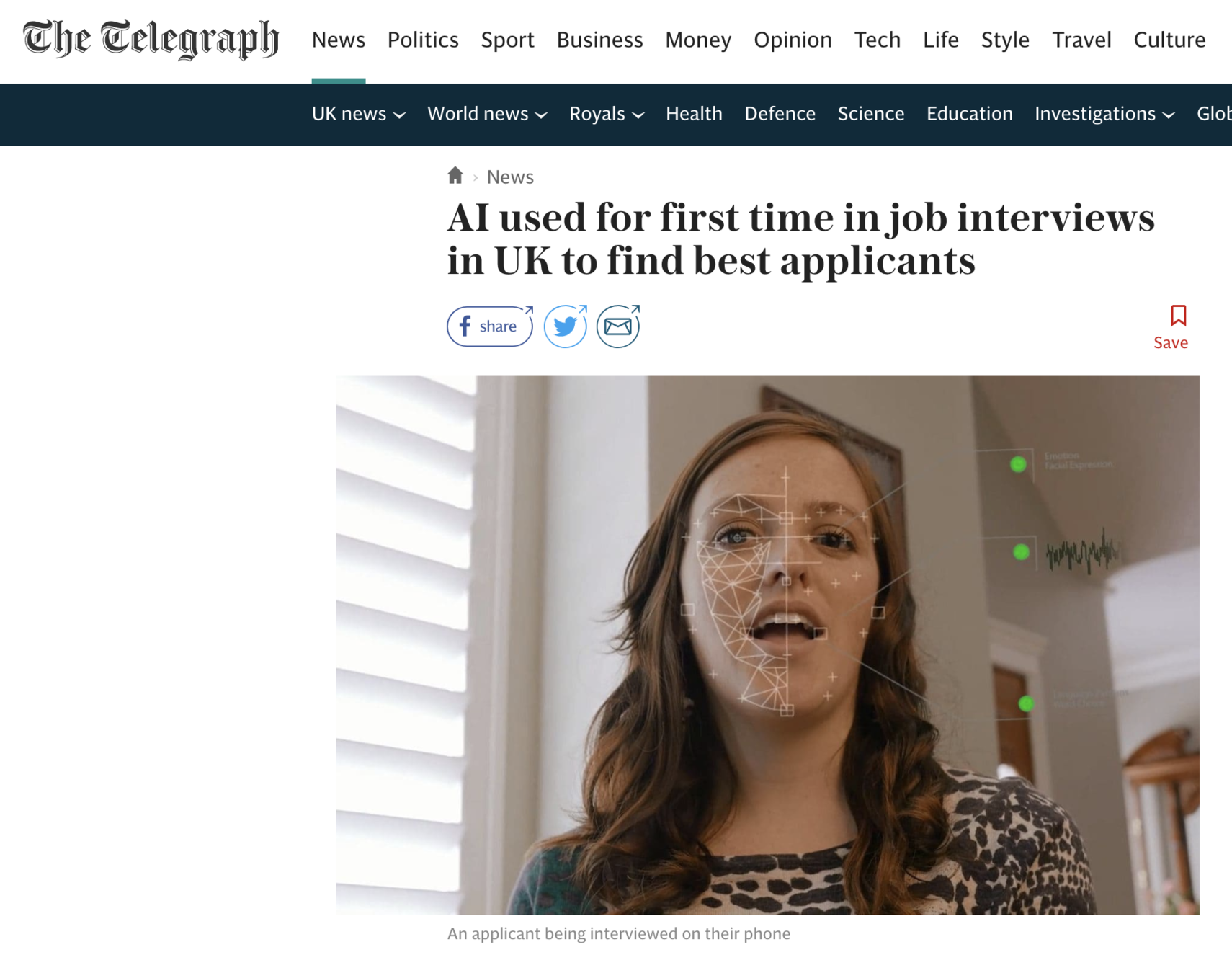

PERFIL ALGORÍTMICO

Newman (2014).

The costs of lost privacy: consumer harm and rising economic inequality in the age of Google.

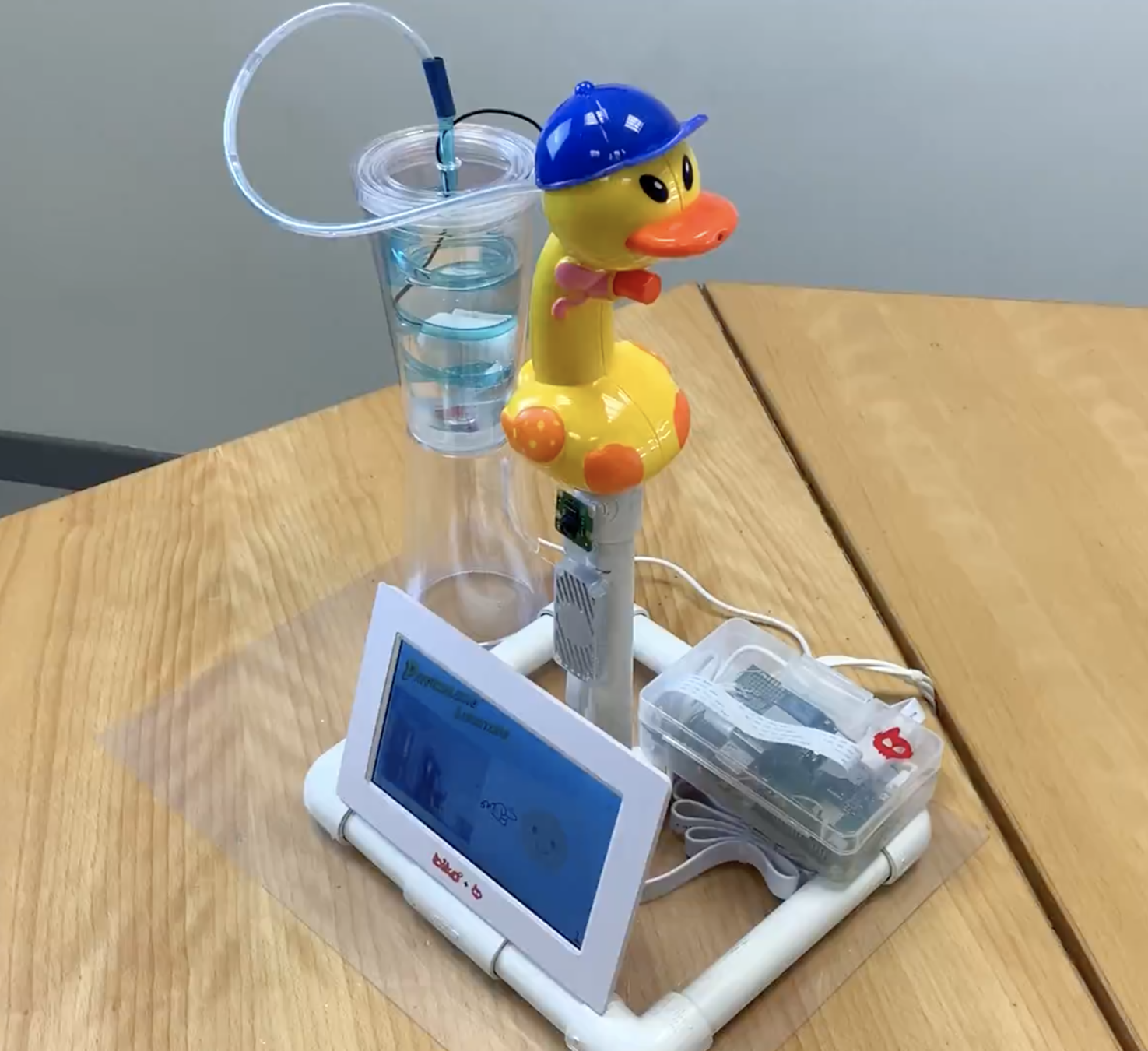

SEBASTIAN, EL ASISTENTE QUE CONTROLA AL ASISTENTE

PROTOTIPO PARA GENERAR REFLEXIÓN

¿CUÁNTO CONTROLAMOS EL ACCESO A NUESTRA INTIMIDAD?

INTERPRELAR SOBRE LA NECESIDAD DE CONTROL

+

DECISION

POINTS

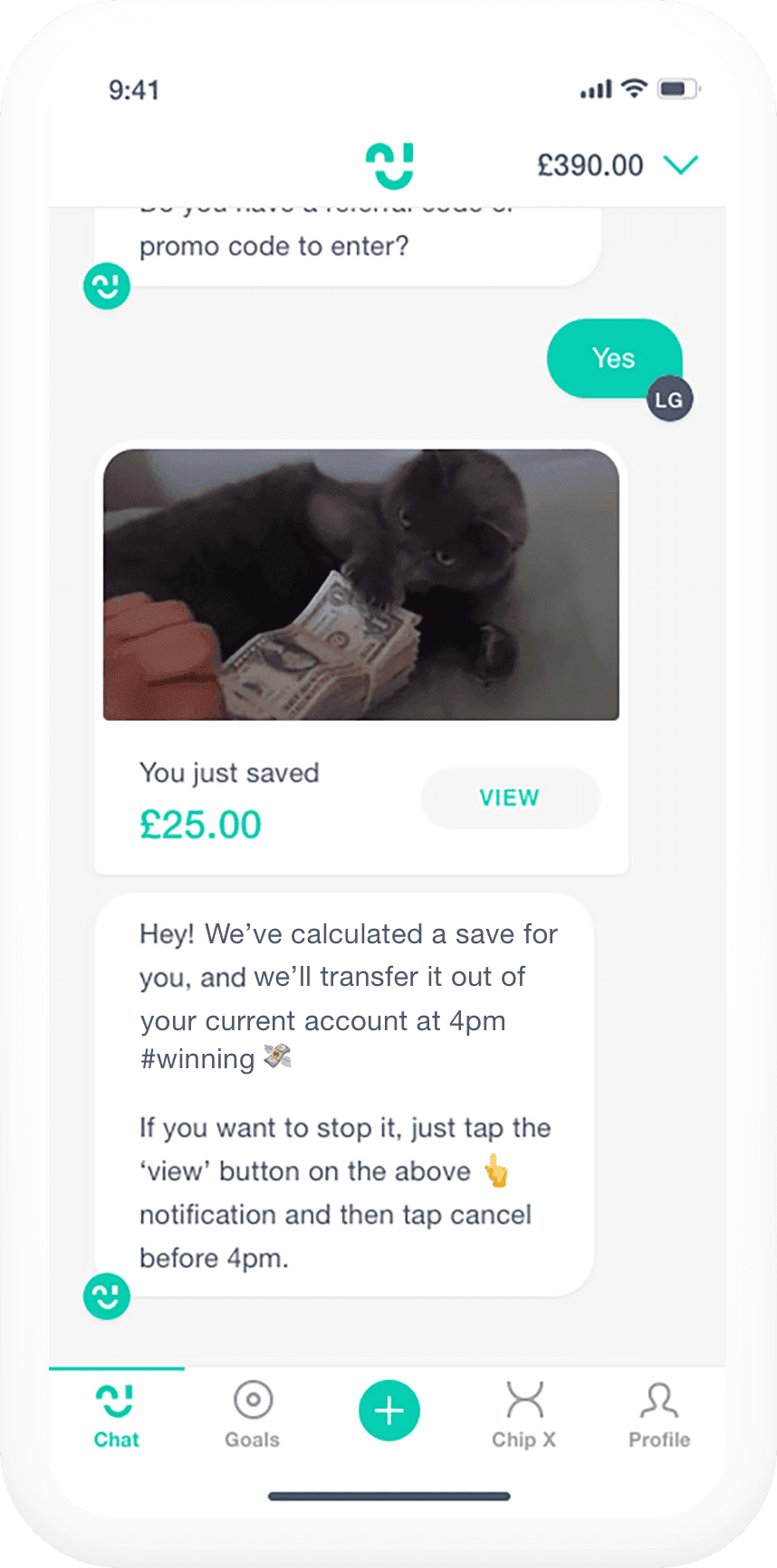

SUPUESTO USER CENTRIC

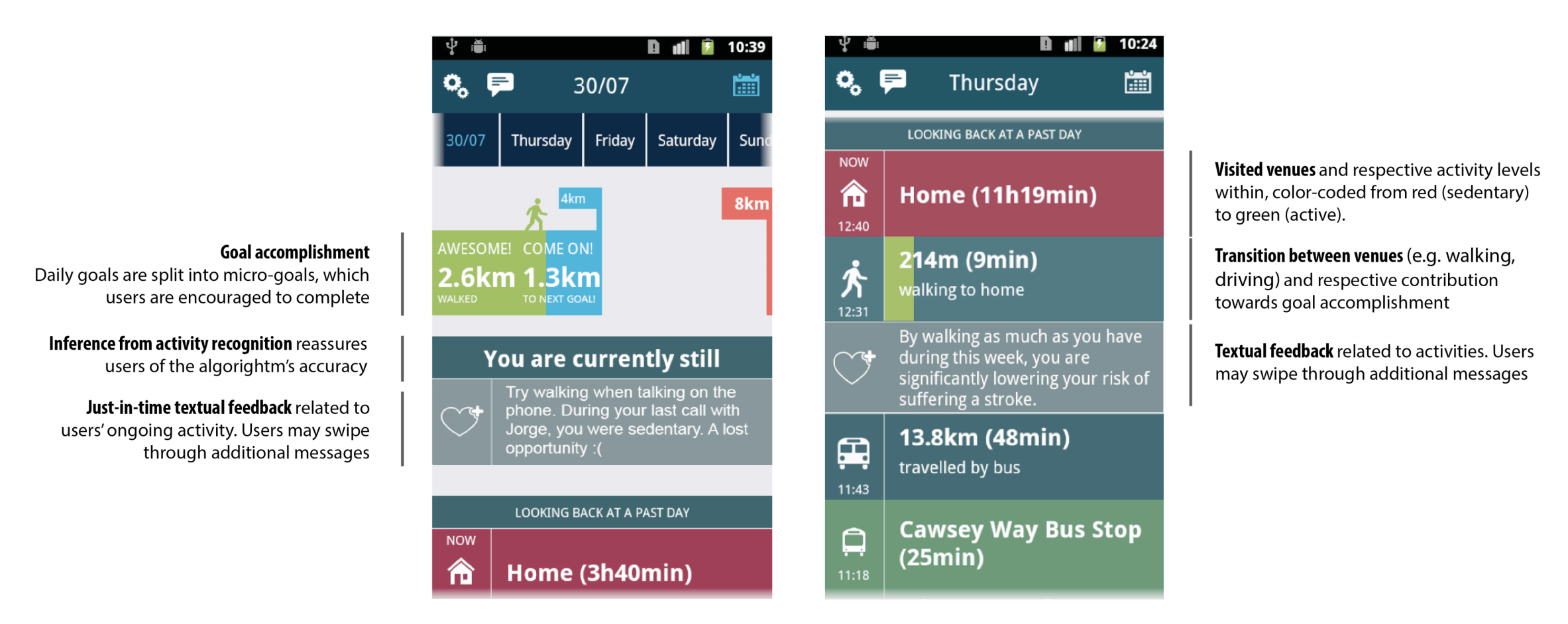

CUALQUIER DISEÑO TECNOLÓGICO ESTABLECE UNA DIMENSIÓN NORMATIVA

El diseño busca influenciar el comportamiento con una intencionalidad específica

Cita de Ariel Guersenzvaig

Paper app Habito. Karapanos (2016). Designing for different stages in behavior change

30% marcó su objetivo

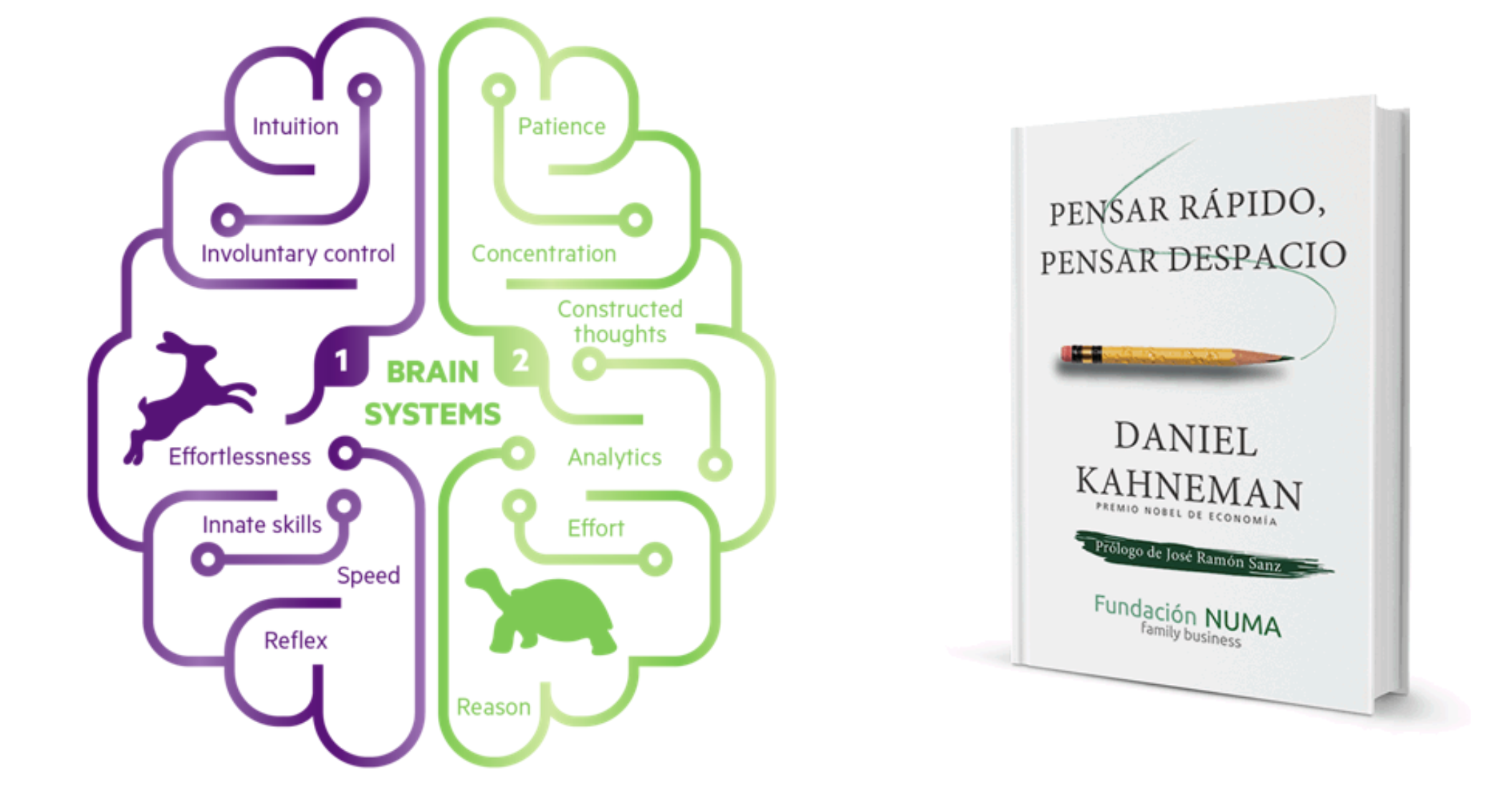

“En el caso improbable de que se hiciera una película sobre este libro, el Sistema 2 sería un personaje secundario que se cree protagonista“

DANIEL KAHNEMAN

The Human potential Gap

https://www.youtube.com/watch?v=UyEm4G_BC68&feature=emb_logo

LIMITACIONES DE PROCESAMIENTO

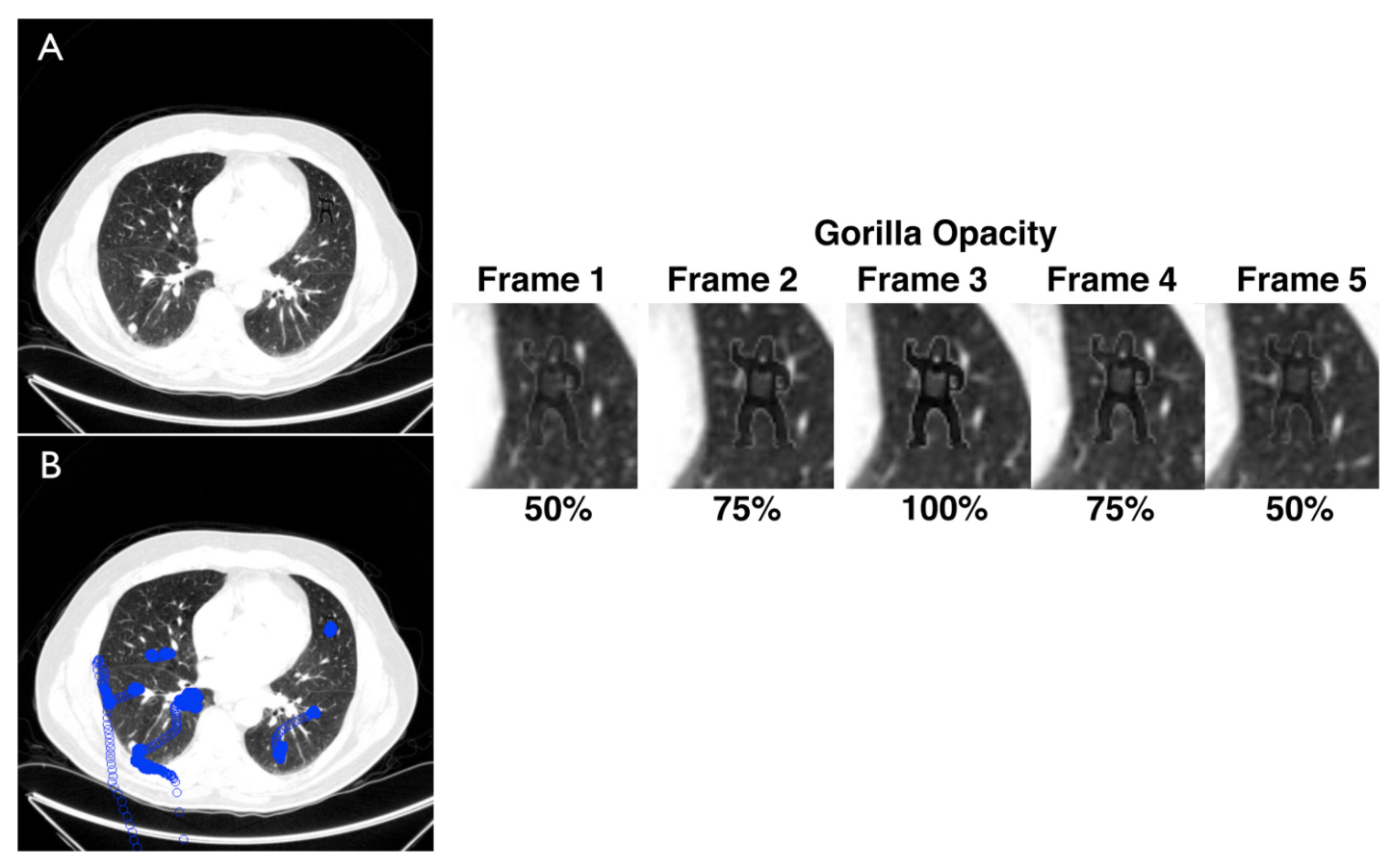

83% no vió al gorila (20/24)

Drew, T., Vo, M. L. H. & Wolfe, J. M. (2013). “The invisible gorilla strikes again: Sustained inattentional blindness in expert observers.

LIMITACIONES DE atención

Juego de la princesa (de Henry Hardin, 1905). Online: http://sprott.physics.wisc.edu/pickover/esp.html

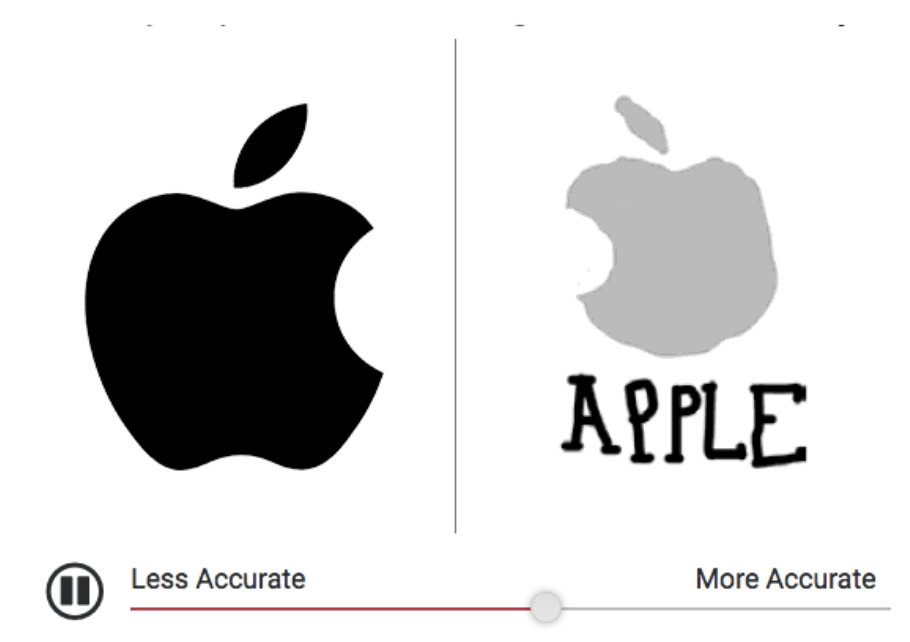

LIMITACIONES DE MEMORIA

Atreveros a dibujar el de Starbucks, Addidas o IKEA

https://www.signs.com/branded-in-memory/

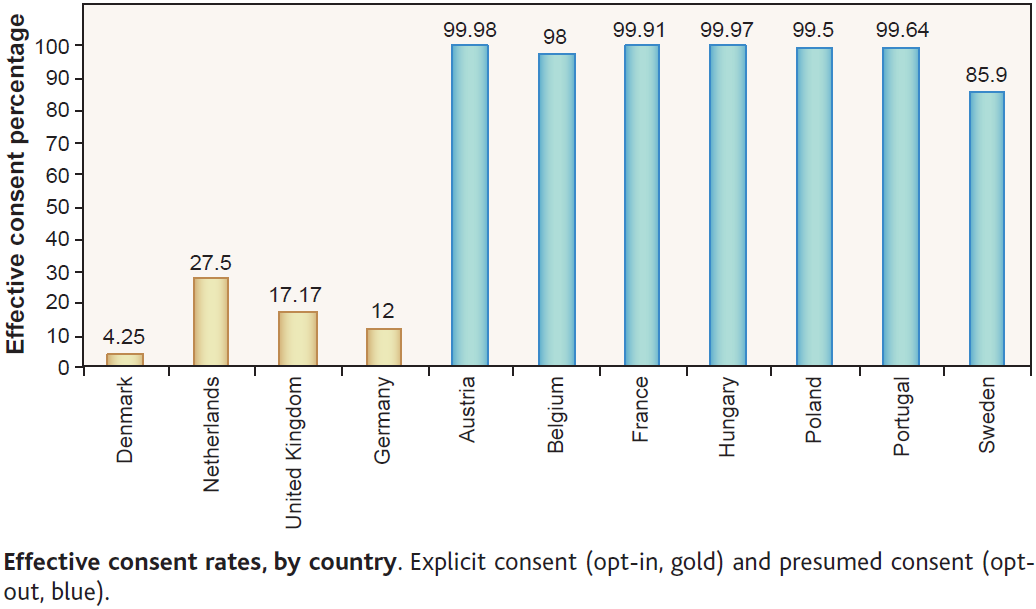

Libertarian Paternalism

Aspecto de la arquitectura de elección que altera el comportamiento de las personas de una manera predecible, sin prohibir ninguna opción, de acuerdo con sus intereses según lo juzguen ellos mismos.

Johnson & Goldstein (2003), ‘Do Defaults Save Lives?', Science, Vol. 302

PATORNALISMO

LIBERTARIO

PROTOTIPO PARA GENERAR REFLEXIÓN

¿hasta qué punto permitiremos que la tecnología modele nuestro comportamiento hacia la normatividad?

https://www.youtube.com/watch?v=nWlrhRf-qHo

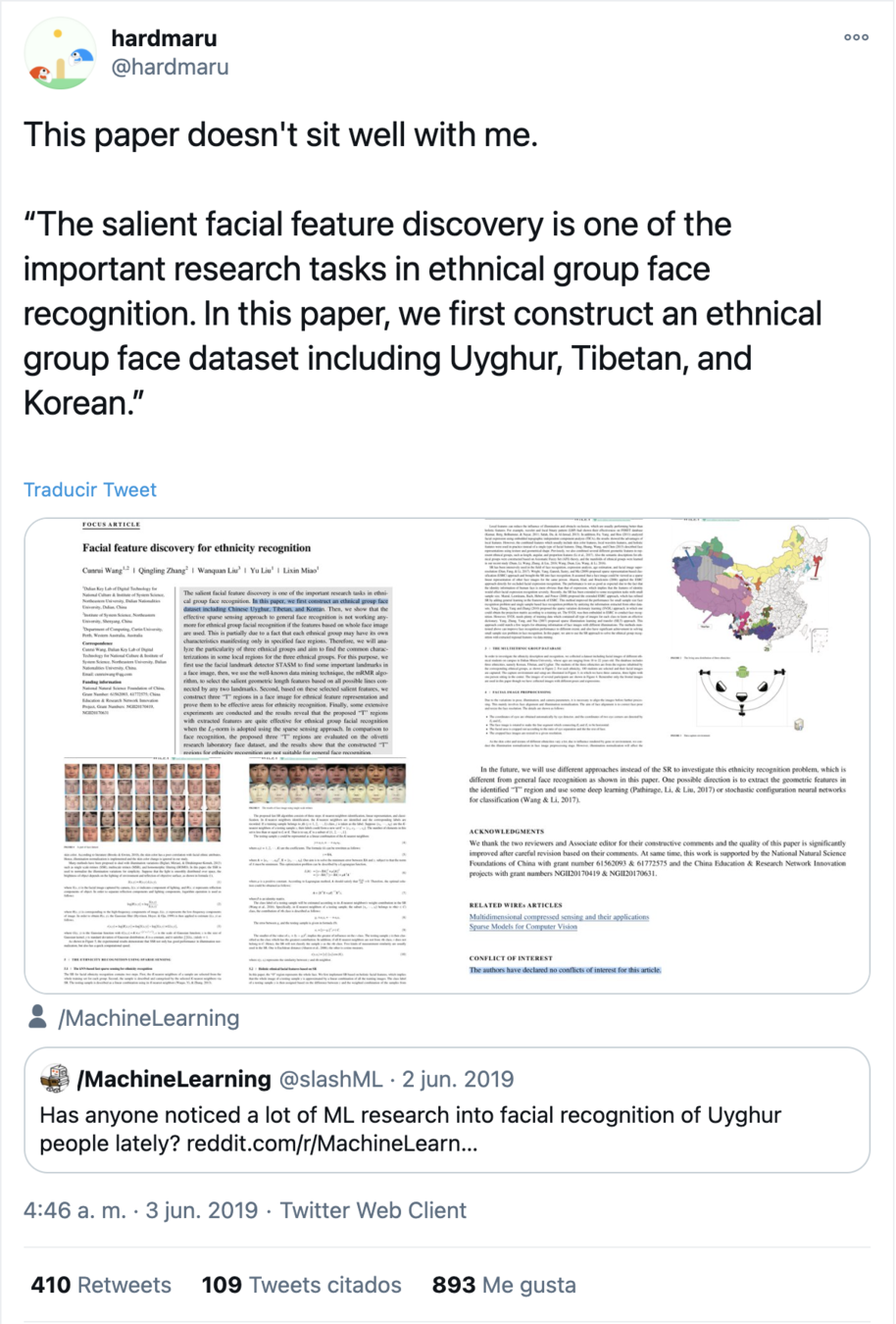

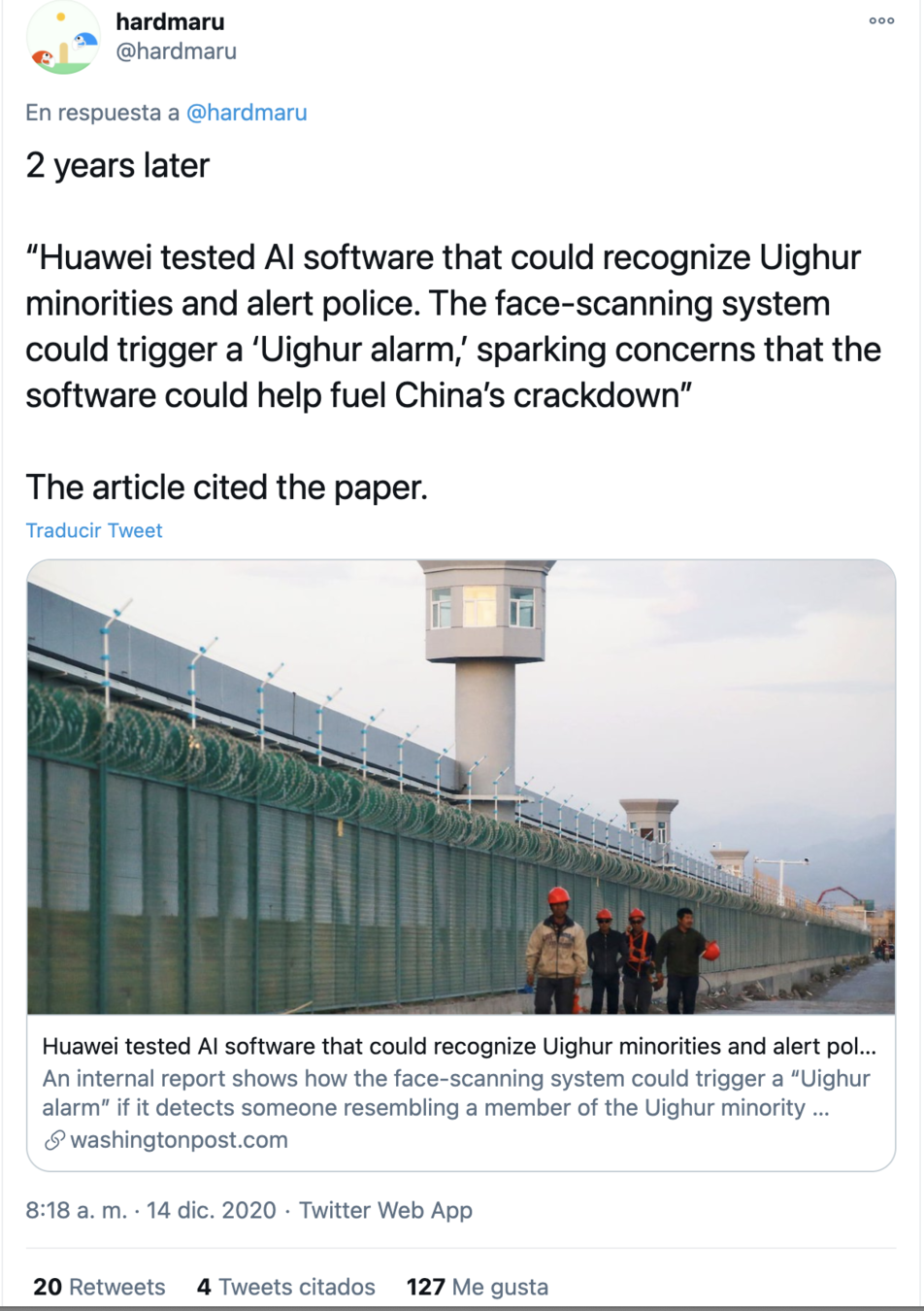

SUPUESTO TECNOLOGÍA NEUTRAL

TODA DECISIÓN TECNOLÓGICA ES POLÍTICA

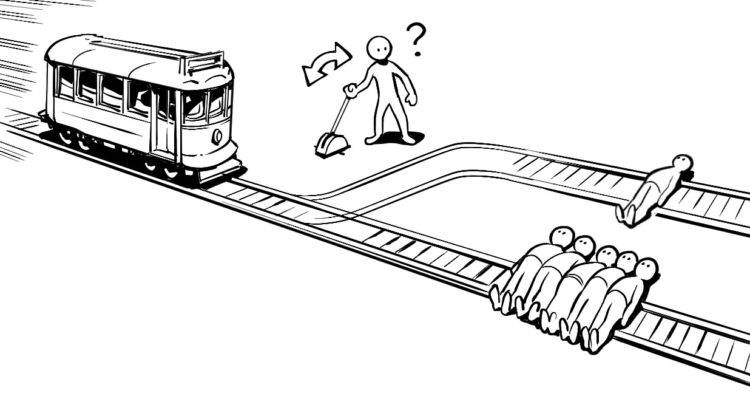

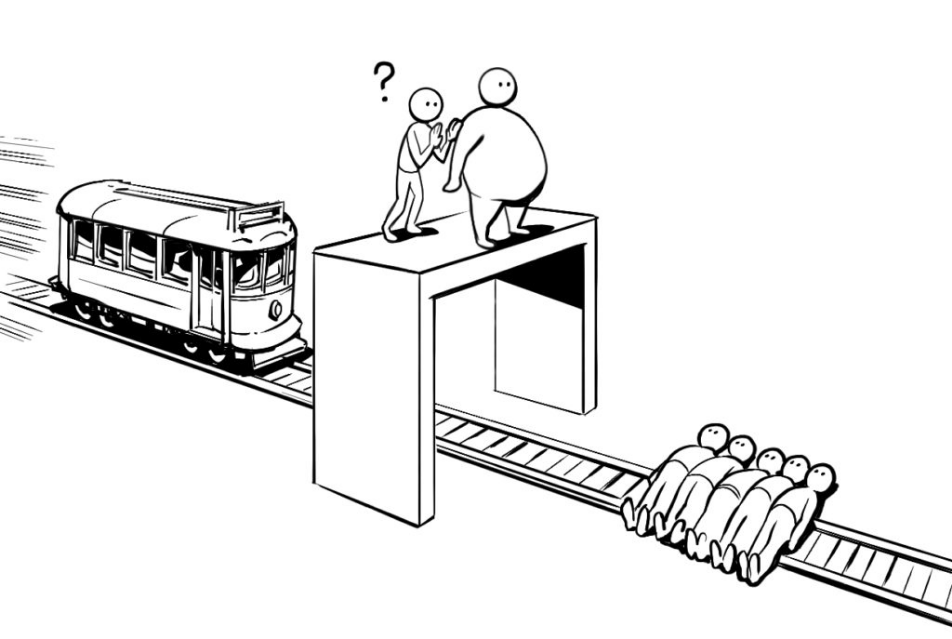

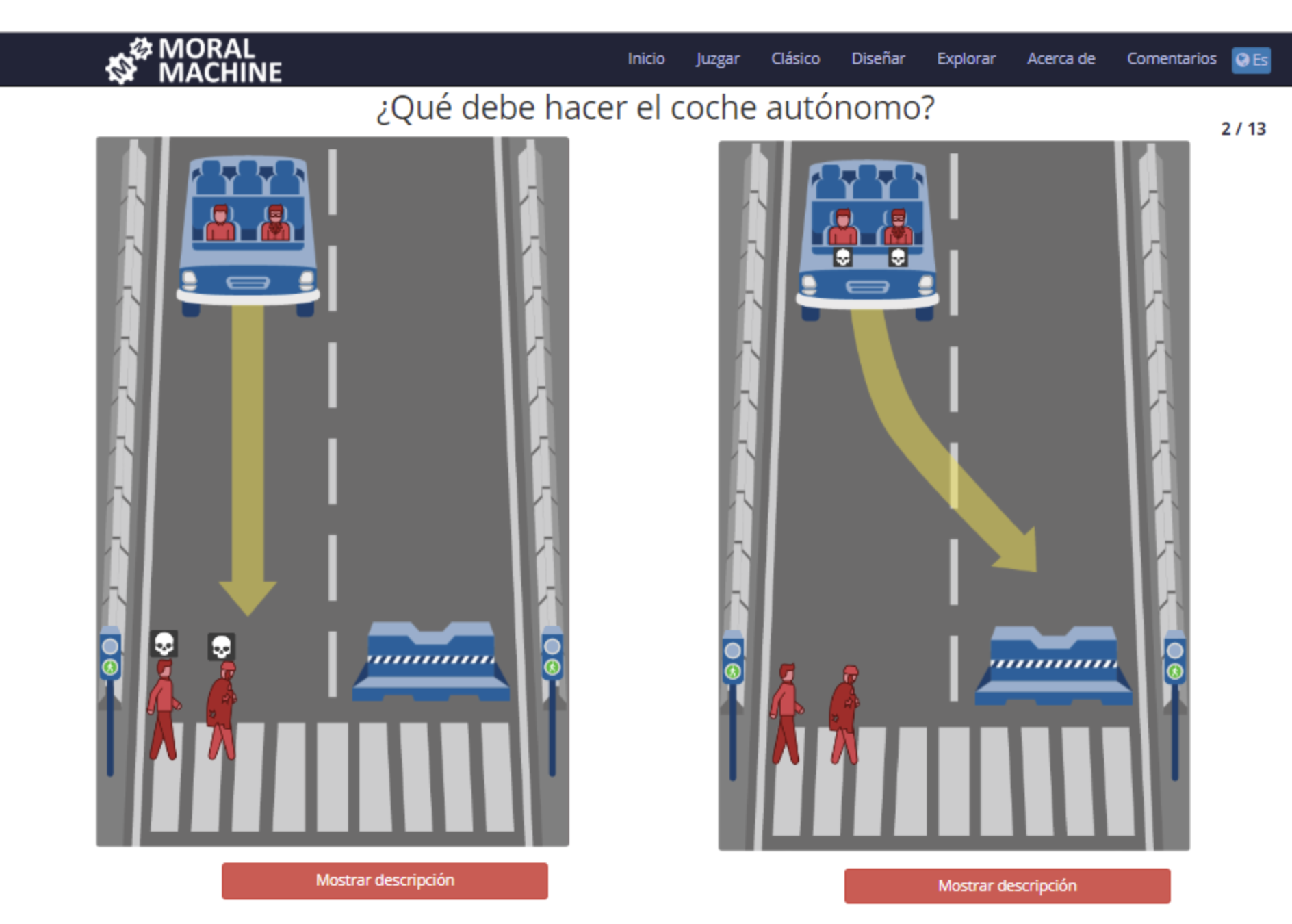

DILEMA DEL TRANVÍA

Ante un accidente inminente un coche autónomo tiene dos posibilidades, atropellar a un peatón o estrellarse y matar a su ocupante. ¿Qué debe hacer el coche autónomo?

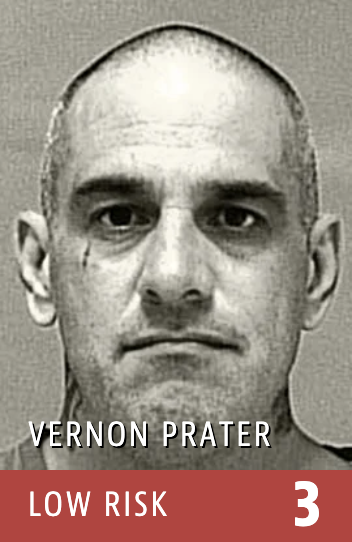

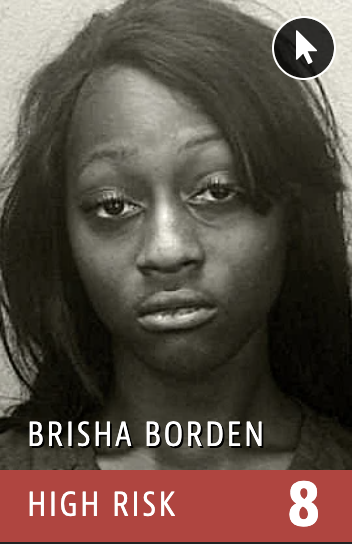

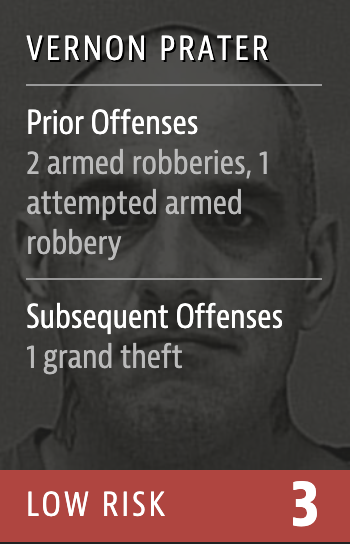

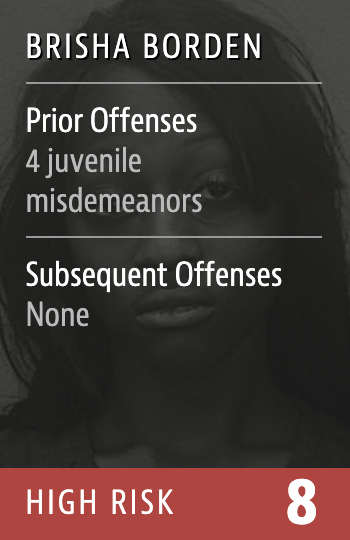

Angwin, J., Larson, J., Mattu, S., & Kirchner, L. (2016). Machine Bias.

https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing

Catherina Xu & Tulsee Doshi (2019). https://ai.googleblog.com/2019/12/fairness-indicators-scalable.html

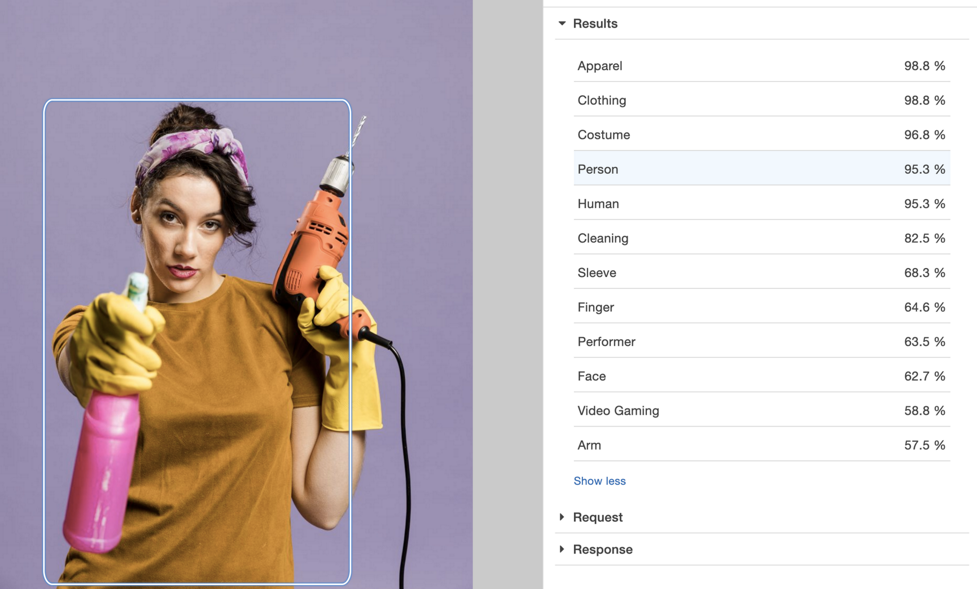

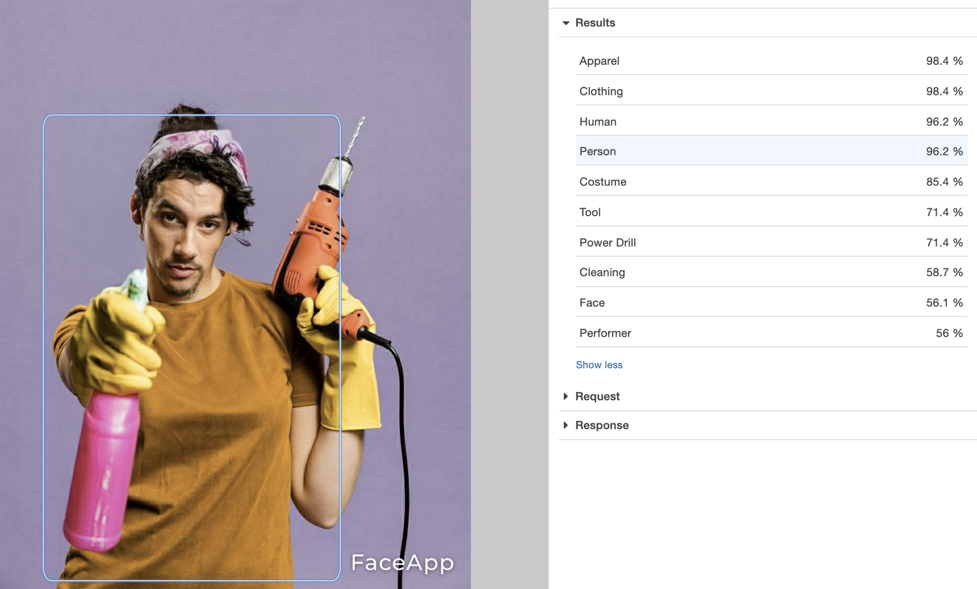

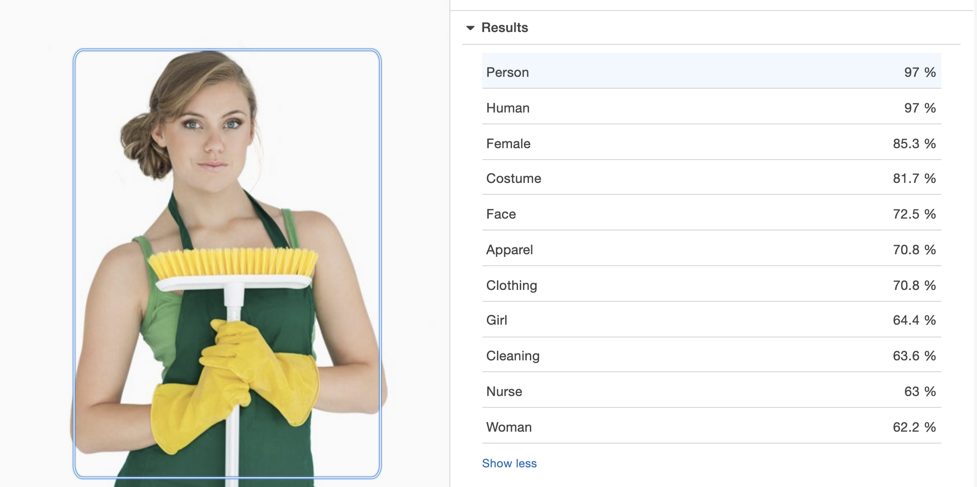

SESGO/POLÍTICA EN LA RECOPILACIÓN DE DATOS

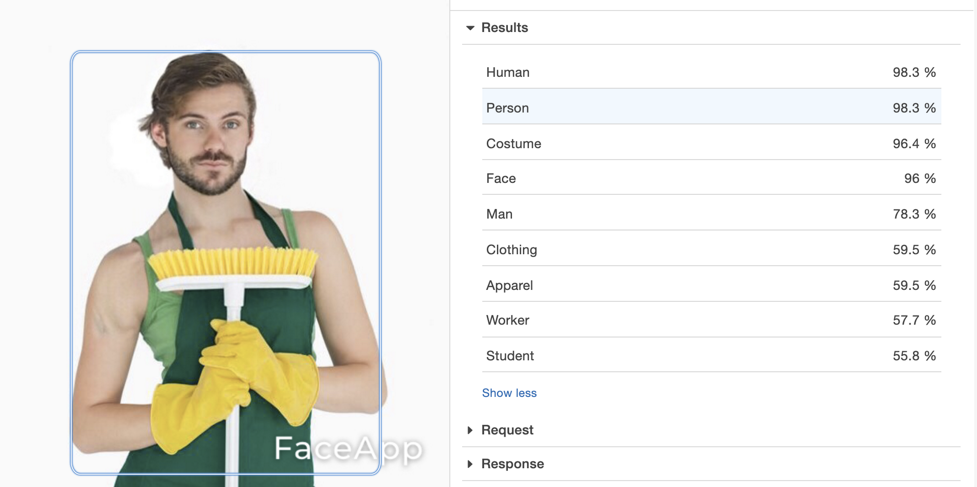

DeVries, Misra, Wang & Van der Maaten (2019). Does Object Recognition Work for Everyone?

SESGO/POLÍTICA EN EL FUNCIONAMIENTO

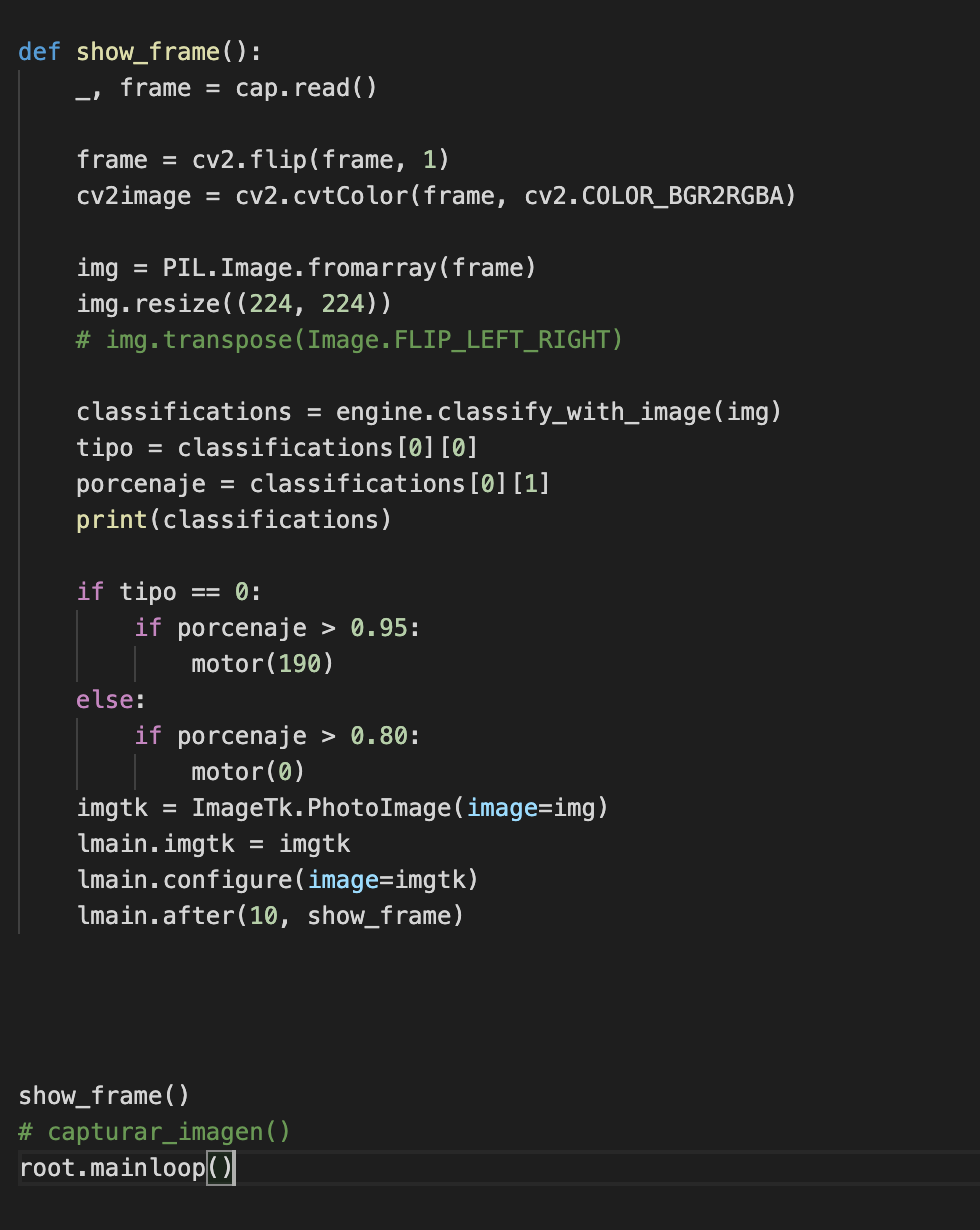

EL AUTOMÁGICO TRAJE DEL EMPERADOR

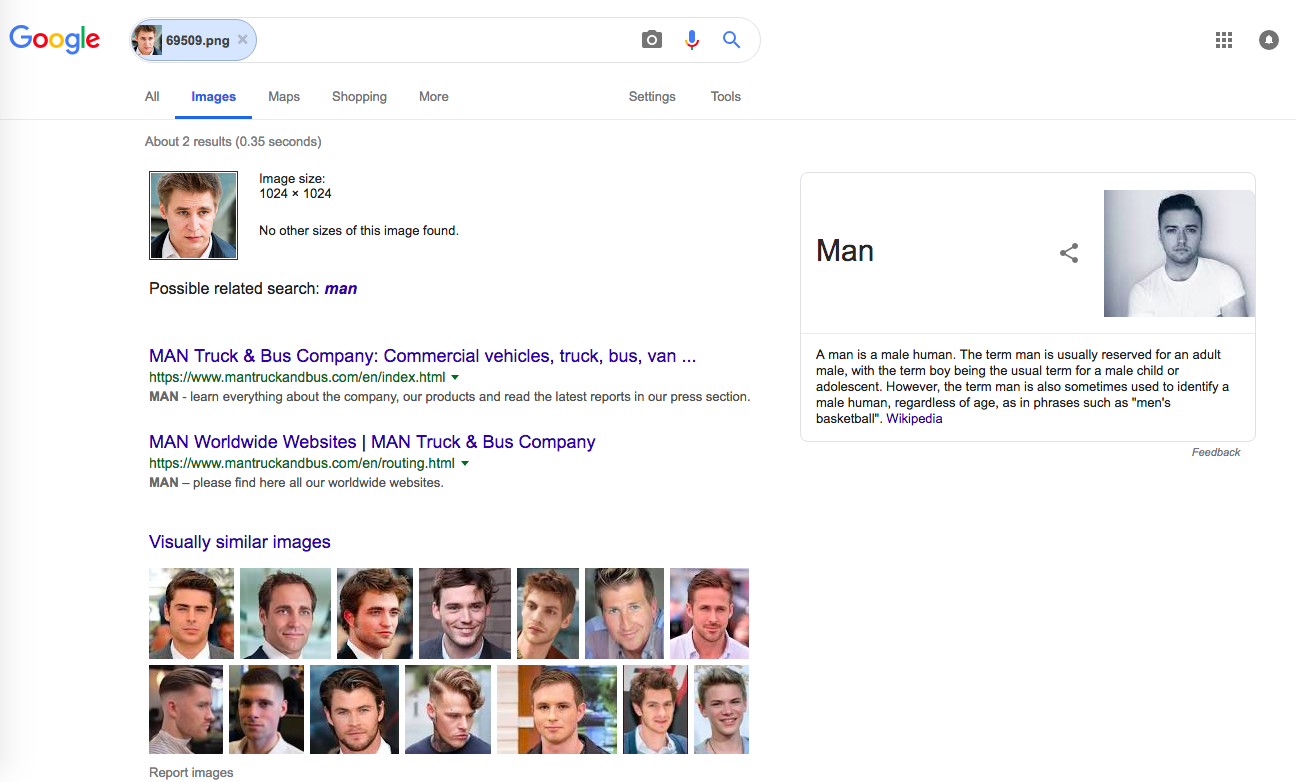

EXPERIMENTO PARA CONOCER REALIDAD

¿CÓMO DE BIEN FUNCIONAN LAS CAJAS NEGRAS DEL RECONOCIMIENTO DE IMAGEN?

RECONOCER LOS DILEMAS ÉTICOS ES PARTE DE LA

LABOR ÉTICA